Teste A/B é uma das práticas mais sólidas e confiáveis quando o objetivo é tomar decisões baseadas em evidência, não em opinião. Em um ambiente digital onde cada clique, cada segundo de atenção e cada conversão têm custo real, a capacidade de comparar variações de forma controlada transforma achismos em aprendizado acumulável. Mais do que uma técnica pontual de marketing, trata-se de um método de experimentação contínua que sustenta crescimento previsível, otimização progressiva e maturidade estratégica.

Teste A/B: o que é, de onde surgiu e por que se tornou essencial

O Teste A/B consiste em comparar duas versões de um mesmo elemento — página, anúncio, e-mail, funcionalidade ou fluxo — para identificar qual delas apresenta melhor desempenho segundo um critério previamente definido. A lógica é simples, quase intuitiva: divide-se o tráfego de forma aleatória entre a versão A (controle) e a versão B (variação), mede-se o comportamento dos usuários e analisa-se o resultado.

Apesar de hoje ser associado quase automaticamente a marketing digital e otimização de conversão, o princípio do Teste A/B é anterior à internet. Ele nasce no campo da estatística experimental, especialmente em ambientes industriais e científicos, onde a comparação controlada de variáveis era a única forma de isolar causa e efeito. O que mudou foi a escala e a velocidade. No digital, experimentos que antes levariam meses passaram a gerar respostas em dias — às vezes em horas.

Essa aceleração criou uma mudança silenciosa, porém profunda, na forma como produtos e estratégias são construídos. Em vez de grandes apostas baseadas em intuição ou hierarquia, empresas maduras passaram a evoluir por ciclos curtos de hipótese, teste e aprendizado. O Teste A/B tornou-se o mecanismo operacional dessa mentalidade.

Há um motivo claro para sua adoção massiva: ele reduz risco. Toda mudança em um site ou campanha carrega incerteza. Alterar um botão, um texto ou um layout pode aumentar conversão, mas também pode destruí-la. O Teste A/B permite avançar sem dar saltos no escuro, criando um ambiente onde errar custa menos e aprender custa quase nada.

Como o Teste A/B funciona na prática: lógica, estrutura e critérios

Embora o conceito seja simples, o funcionamento correto de um Teste A/B exige rigor. Não se trata de “subir duas versões e ver qual ganha”. Há uma estrutura lógica que, quando ignorada, transforma o teste em ruído estatístico.

O ponto de partida é sempre uma hipótese clara. Não se testa por testar. Um bom teste nasce de uma pergunta específica: “Se alterarmos este elemento, este comportamento tende a mudar por este motivo”. Essa hipótese conecta observação prévia, entendimento do usuário e expectativa mensurável. Sem isso, o resultado até pode indicar um vencedor, mas dificilmente gerará aprendizado reaproveitável.

Definida a hipótese, escolhe-se a variável a ser testada. Em um Teste A/B clássico, apenas um elemento deve variar entre as versões. Quando múltiplas mudanças são feitas simultaneamente, perde-se a capacidade de atribuir o resultado a uma causa específica. O teste deixa de ser diagnóstico e vira tentativa.

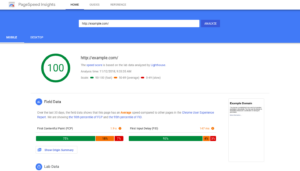

Outro ponto crítico é a definição da métrica de sucesso. Conversão é o exemplo mais comum, mas está longe de ser o único. Dependendo do contexto, pode-se medir taxa de clique, tempo de permanência, profundidade de rolagem, retenção, receita por usuário ou qualquer indicador que represente valor real para o negócio. Métricas de vaidade produzem decisões fracas.

A divisão do tráfego precisa ser aleatória e equilibrada. Isso garante que fatores externos — horário, dispositivo, perfil do usuário — não distorçam o resultado. Ferramentas modernas cuidam dessa aleatoriedade, mas a responsabilidade de interpretar corretamente continua sendo humana.

Por fim, o teste deve rodar tempo suficiente para atingir significância estatística. Encerrar um Teste A/B porque “já pareceu melhor” é um dos erros mais comuns. Flutuações iniciais são normais. O que importa é a consistência do resultado ao longo de um volume mínimo de dados.

Teste A/B aplicado à otimização de conversão: onde o impacto é mais visível

É no campo da otimização de conversão que o Teste A/B demonstra sua força com mais clareza. Pequenas alterações, quando testadas de forma sistemática, acumulam ganhos que seriam invisíveis em uma análise isolada.

Páginas de vendas são um exemplo clássico. Um ajuste no título pode alinhar melhor a proposta de valor com a expectativa do visitante. Uma mudança na hierarquia visual pode reduzir fricção cognitiva. Um botão com texto mais específico pode diminuir ambiguidade e aumentar ação. Nenhuma dessas decisões deveria ser tomada apenas por gosto pessoal ou tendência de design.

Formulários também se beneficiam intensamente. Campos em excesso, rótulos pouco claros ou etapas mal distribuídas costumam derrubar conversões de forma silenciosa. Testes simples — como reduzir campos, alterar a ordem ou ajustar microcopys — frequentemente geram aumentos relevantes sem qualquer investimento em tráfego adicional.

No e-mail marketing, o Teste A/B é quase obrigatório. Assuntos, pré-headers, chamadas, estrutura de conteúdo e até o horário de envio podem ser comparados. O impacto cumulativo desses testes, ao longo de meses, redefine completamente a performance de uma base.

Anúncios pagos talvez sejam o ambiente mais agressivo para experimentação. Cada clique tem custo imediato. Testar criativos, mensagens e formatos não é apenas uma boa prática, mas uma questão de sobrevivência financeira. Aqui, o Teste A/B deixa de ser apenas uma ferramenta de otimização e passa a ser um mecanismo de controle de desperdício.

Teste A/B além do marketing: produto, UX e tomada de decisão

Limitar o Teste A/B ao marketing é subutilizar seu potencial. Empresas orientadas a produto utilizam o mesmo princípio para validar funcionalidades, fluxos e decisões de experiência do usuário.

Ao lançar um novo recurso, por exemplo, é comum surgir a dúvida: isso realmente melhora a vida do usuário ou apenas adiciona complexidade? Um Teste A/B pode expor parte da base à nova funcionalidade enquanto mantém outra parte no fluxo antigo. Métricas de uso, retenção e satisfação revelam rapidamente se a mudança entrega valor real.

Na experiência do usuário, microdecisões têm impacto acumulado. O posicionamento de um menu, o número de passos em um onboarding, a clareza de uma mensagem de erro. Tudo isso pode ser testado de forma controlada. O resultado é uma evolução menos ideológica e mais empírica do produto.

Há também um efeito cultural importante. Organizações que adotam Teste A/B como prática recorrente tendem a reduzir disputas internas baseadas em opinião. A pergunta deixa de ser “quem está certo” e passa a ser “o que os dados mostram”. Isso não elimina o papel da experiência humana, mas a ancora em evidência.

Esse ponto é crucial: Teste A/B não substitui pensamento estratégico. Ele valida ou invalida hipóteses criadas por pessoas que entendem o contexto. Quando usado sem reflexão, vira uma fábrica de números sem direção. Quando integrado à estratégia, torna-se um acelerador de aprendizado organizacional.

Erros comuns em Teste A/B e como evitá-los

A popularização do Teste A/B trouxe também uma série de distorções. Muitos testes falham não por limitação do método, mas por uso inadequado.

Um erro frequente é testar sem volume suficiente. Sites com pouco tráfego dificilmente atingem significância estatística em prazos razoáveis. Nesses casos, insistir em Teste A/B pode gerar conclusões falsas. Alternativas qualitativas ou testes sequenciais podem ser mais apropriadas.

Outro problema recorrente é a multiplicidade de testes simultâneos sem controle. Quando várias experiências rodam ao mesmo tempo, interagindo entre si, o resultado de cada uma se contamina. Sem um planejamento claro, a leitura dos dados se torna confusa.

Há também a tentação de validar decisões já tomadas. O teste nasce enviesado, com alterações feitas para “provar” uma ideia, não para questioná-la. Esse comportamento transforma o Teste A/B em uma formalidade, não em uma ferramenta de descoberta.

Interpretar resultados sem considerar contexto é outro desvio perigoso. Um teste pode vencer estatisticamente, mas gerar efeitos colaterais negativos no longo prazo, como aumento de churn ou queda de percepção de marca. Métricas isoladas não contam a história completa.

Evitar esses erros exige disciplina, documentação e uma mentalidade de aprendizado contínuo. Cada Teste A/B deveria gerar não apenas um vencedor, mas um insight claro sobre comportamento do usuário.

Teste A/B como estratégia contínua de crescimento e aprendizado

O maior valor do Teste A/B não está em um único experimento vencedor, mas no acúmulo de decisões melhores ao longo do tempo. Quando tratado como processo contínuo, ele constrói uma base de conhecimento que diferencia negócios medianos de organizações verdadeiramente orientadas a dados.

Esse acúmulo cria padrões. Com o tempo, torna-se possível antecipar comportamentos, reconhecer o que tende a funcionar e identificar rapidamente o que não faz sentido testar. O ciclo de aprendizado se acelera.

Empresas que dominam Teste A/B não testam tudo. Elas escolhem com critério onde investir energia experimental. Focam em alavancas de impacto real e evitam otimizações cosméticas que consomem recursos sem retorno proporcional.

Há também um ganho de maturidade estratégica. Decisões deixam de ser eventos isolados e passam a fazer parte de um sistema de evolução. O site, o produto e a comunicação nunca estão “prontos”; estão sempre em versão melhorável.

Em um cenário de competição intensa, onde margens são pressionadas e atenção é escassa, essa capacidade de aprender mais rápido que o mercado se torna vantagem competitiva. Teste A/B, quando bem aplicado, não é apenas uma técnica de otimização. É uma filosofia operacional baseada em evidência, humildade intelectual e melhoria contínua.

No fim, o que diferencia quem usa Teste A/B de quem apenas fala sobre ele é a consistência. Testar uma vez é curioso. Testar sempre é estratégico. É nesse ponto que a experimentação deixa de ser tática e passa a ser estrutural.